출처: 길벗

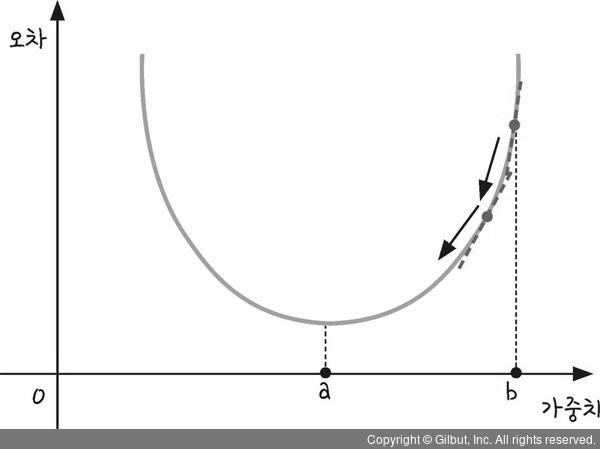

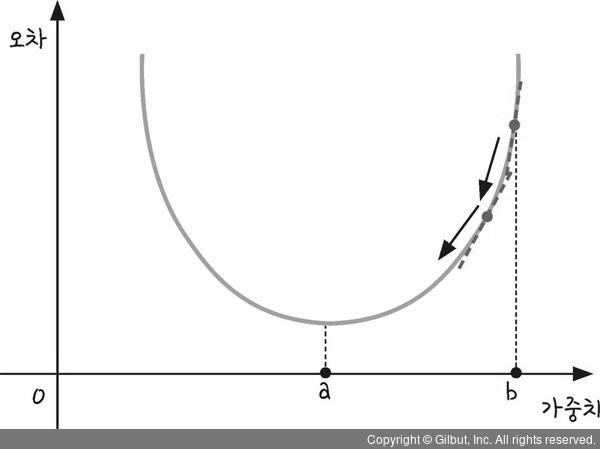

경사 하강법(Gradient Descent)은 최적화 기법 중 하나로, 함수의 기울기를 따라 내려가면서 최적의 값을 찾는 알고리즘이다. 머신러닝과 딥러닝에서 비용 함수(Cost Function)를 최소화하는 데 사용된다.

경사 하강법은 특정 함수의 기울기를 이용해 "최소값(Local Minimum)"을 찾아가는 반복적인 최적화 방법이다.

경사 하강법은 다음과 같은 수식으로 표현된다:

\[ \theta_{t+1} = \theta_t - \alpha \nabla J(\theta_t) \]

\( \theta_t \): 현재 가중치

\( \alpha \): 학습률 (Learning Rate)

\( \nabla J(\theta_t) \): 비용 함수의 기울기

이 수식을 반복적으로 적용하여 최적의 \( \theta \) 값을 찾는다.

[예시]

\[ \begin{align} \omega_{ij}^{new} &= \omega_{ij}^{old} + \Delta\omega_{ij} \\ &= \omega_{ij}^{old} + L \cdot \frac{\partial \omega_{ij}}{\partial L} \\ b_{ij}^{new} &= b_{ij}^{old} + \Delta b_{ij} \\ &= b_{ij}^{old} + L \cdot \frac{\partial b_{ij}}{\partial L} \end{align} \]